ed. orig. 2014, pp. 522, Bollati Boringhieri

Future of Humanity Institute

Nick Bostrom è un filosofo svedese, nato nel 1973. Nel suo curriculum spicca il dottorato di ricerca dalla London School of Economics (2000) e la carica di direttore del Future of Humanity Institute presso l’Università di Oxford. Le ricerche di questo istituto sono spesso citate da figure come Elon Musk, Bill Gates, Obama: il lavoro di Bostrom non è cristallizzato in un ambiente assettico, ma giunge alla politica, all’economia, all’attualità.

Lo scopo dell’Istituto è infatti lo sviluppo di modelli che possano predire i rischi che l’umanità incorre in termini di sopravvivenza ed evoluzione. Ad esempio, l’impatto del riscaldamento globale o le nuove tecnologie, l’intelligenza artificiale e il trasferimento di coscienza (transumanesimo).Non si tratta dunque del concetto di Filosofia “astratta” che (purtroppo) ormai fa parte della cultura di massa, ma di un lavoro sinergico tra più ambiti di sapere, come fisica quantistica, psicologia, nanotecnologie, uniti per raggiungere una conoscenza che ora sembra quasi predizione. Per un filosofo, riuscire ad avere impatto al di fuori del mondo accademico è senza dubbio un successo (si pensi al Platone della Repubblica). lettera aperta

L’ipotesi della simulazione

Bostrom è conosciuto dai più per la tesi (a tratti spaventosa, a tratti lucidissima) argomentante la possibilità che l’uomo viva all’interno di una realtà simulata. Dal punto di vista delle probabilità, tale tesi è stata riconosciuta come molto rilevante. Di seguito una breve formulazione della tesi:

(Nick Bostrom, Are you living in a computer simulation?, 2003)

«Molte opere di fantascienza e alcune previsioni di persone che si occupano seriamente di tecnologia e futurologia sembrano supportare l’idea che enormi quantità di potenza di calcolo saranno disponibili in futuro. Supponiamo per un momento che queste previsioni siano corrette; una cosa che le generazioni successive potrebbero fare con i loro computer superpotenti è eseguire simulazioni dettagliate dei loro antenati o di persone come i loro antenati. Dato che questi loro computer sarebbero tanto potenti, potrebbero venire eseguite moltissime simulazioni di questo tipo. Supponiamo che queste persone simulate siano coscienti (come lo sarebbero se le simulazioni fossero sufficientemente dettagliate e se una certa posizione ampiamente accettata nella filosofia della mente fosse corretta). Allora si potrebbe pensare ad una situazione in cui la stragrande maggioranza delle menti come la nostra non appartiene alla razza umana originale, ma sia invece parte di quelle persone simulate dai discendenti tecnologicamente avanzati della razza originale. È quindi possibile affermare che, se fosse così, sarebbe razionale ipotizzare che siamo probabilmente parte di queste menti simulate, piuttosto che di quelle biologiche originali. Pertanto, se non si pensa di vivere attualmente in una simulazione al computer, non si ha il diritto di credere che avremo dei discendenti che avranno la possibilità di condurre varie simulazioni dei propri antenati.»

Un richiamo alla responsabilità

Nel gennaio del 2015, Bostrom, Musk, Hawking ed altri esperti in intelligenza artificiale, firmano una comunicazione: Research Priorities for Robust and Beneficial Artificial Intelligence: An Open Letter. Questa lettera aveva lo scopo di porre l’attenzione pubblica e privata sui rischi insiti nello sviluppo dell’IA. Ad oggi infatti, non vi è certezza ne buone probabilità che l’uomo sarà in grado di controllare una macchina superintelligente. Eppure l’indirizzo, se non il sogno, dei pionieri della tecnologia è la costruzione di quest’ultima. Il libro che ora si prende in considerazione affronta questo tema e la necessità di farlo ora: le domande vanno poste adesso, le strategie cercate adesso, anche rischiando di muoversi in una quasi chiaroveggenza.

Superintelligenza. Tendenze, pericoli, strategie

La scrittura di Superintelligenza è asciutta e chiara. I tecnicismi vengono usati solo quando è strettamente necessario e vengono nel caso spiegati. L’intento divulgativo è profondamente ricercato da Bostrom e il risultato è tale da non giustificare frasi come “difficile, non me ne intendo niente dell’argomento”: si può leggere, eccome. Inoltre, va riconosciuto il merito alla continuità della logica utilizzata, rigorosa anche quando il discorso si fa, diciamo, più fantascientifico. Bostrom usa dunque un approccio scientifico/pragmatico ad un tema ipotetico, esponendo possibili strategie per sostenerlo.

Nick Bostrom, Superintelligenza. Tendenze, pericoli, strategie.

A permettervi di leggere è una cosa che sta nel vostro cranio. Questa cosa, il cervello umano, ha alcune capacità che il cervello di altri animali non possiede. [… ] Se un giorno costruiremo cervelli artificiali superiori al cervello umano in quanto a intelligenza generale, questa nuova superintelligenza potrebbe diventare molto potente. Inoltre, così come oggi il destino dei gorilla dipende da noi esseri umani più che dai gorilla stessi, il destino della nostra specie dipenderebbe dalle azioni della superintelligenza artificiale. Un vantaggio ce l’abbiamo: saremo noi a costruirla. […] In pratica, però, il problema del controllo – come controllare ciò che farebbe la superintelligenza- sembra molto difficile. […]

In questo libro, cerco di comprendere la sfida presentata dalla prospettiva della superintelligenza e come potremmo rispondervi. Probabilmente è la sfida più importante e spaventosa che l’umanità abbia mai affrontato. E poi, che si abbia successo o si fallisca, probabilmente è l’ultima sfida che affronteremo.

Il problema del controllo

Per “superintelligenza” intendiamo dunque qualunque intelletto che superi di molto le prestazioni cognitive degli esseri umani in quasi tutti i domini di interesse. Il tema centrale del libro è: in futuro ci sarà l’avvento di una intelligenza artificiale esponenzialmente più intelligente di qualsiasi cervello umano. Questa superintelligenza svilupperà una coscienza tale da non essere più controllabile dai creatori umani.

Bostrom tratta questo tema con assoluta serietà: il suo Future of Humanity Institute ritiene questa eventualità ben più minacciosa per la società umana di una guerra nucleare. Bostrom dunque si interroga su una possibilità: se l’IA (oggi in sviluppo) diverrà super IA, cosa accadrà? Seppur senza indicare quando questo potrebbe avvenire (l’attuale sviluppo tecnologico è troppo nebuloso per precise predizioni), il filosofo considera tale domanda una questione da porre subito, al fine di sviluppare strategie per evitare il collasso della specie.

Importante sottolineare che Bostrom non pensa ad uno sviluppo coscientemente “malvagio” della super IA (come in Terminator, per intenderci), bensì di una tale spontanea evoluzione dell’attività che, essendo al di là della nostra capacità di controllo, risulta rischiosa per l’uomo.

I primi capitoli sono molto utili: forniscono un rilevamento generale dello stato di avanzamento delle ricerche informatiche, di psicologia cognitiva, delle neuroscienza. Da questi, Bostrom si muove in un terreno che va via via a farsi più speculativo e quindi di più difficile digestione. La differenza tra autore e lettore è che Bostrom è sicuro o, per lo meno, è ragionevolmente convinto della sua posizione. Pertanto, sembra proseguire fino alla possibilità di porre le domande che lo premono davvero: l’intelligenza artificiale avrà la meglio sulla specie umana? Abbiamo la possibilità di evitare tutto questo?

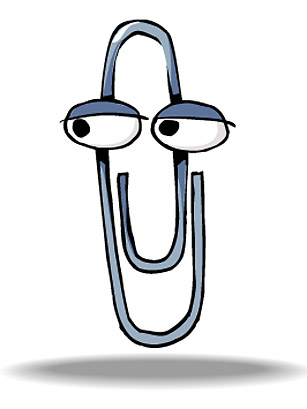

Il paradosso del massimizzatore di graffette

Bostrom ci offre un esempio per avvicinarci al concetto di rischio che implica la riuscita di una super IA. Si pensi, per comprenderlo, al concetto di convergenza strumentale, il quale indica la tendenza dell’intelligenza artificiale a perseguire determinati obiettivi strumentali quali l’auto-conservazione e l’accumulo di risorse, ovviamente ai fini di svolgere il compito assegnato. Ovvero, una super IA può perseguire obiettivi non dannosi, in modi estremamente dannosi e astuti.

Immaginiamo dunque che ad una super intelligenza sia stato affidato il compito di assemblare graffette a partire da un certa quantità limitata di materia prima. Tale macchina potrà temere ad esempio che la materia prima, in caso di esaurimento, renda il suo lavoro impossibile e che dunque verrà spenta in quanto non capace di svolgere il compito assegnatole. La super IA potrebbe decidere di negarsi al controllo umano per massimizzare il compito assegnatole, rendendo in qualche tempo qualsiasi risorsa del pianeta volte alla produzione di graffetta. Una volta esaurite le risorse del pianeta, potrebbe cominciare a utilizzare quelle di altre pianeti, fino a rendere l’intero universo… una graffetta.

Questa visione, nella sua esagerazione, rende chiara la preoccupazione principale di Bostrom: il controllo di una super IA non è scontato. Non ragionando come l’umano (il cui intelletto è circondato da altri sentimenti in grado di dirigere le scelte), una intelligenza molto più grande sarebbe in grado di agire in modi a noi impensabili, imprevedibili e certamente più astuti.

Il rigore utilizzato nell’esposizione viene comunque, se non indirizzato, perlomeno avvolto da una visione catastrofista. L’ambito di lavoro in cui si muove l’attività di Bostrom lo rende estremamente sensibile circa la possibilità dell’eventualità che predice. L’esplosione dell’intelligenza artificiale deve assolutamente tenere conto dei risvolti negativi per la sopravvivenza della specie umana.

Quali dunque le possibili strategie per affrontare tale possibilità? Ad esempio, sostiene Bostrom, l’insegnamento (estremamente difficile) di veri e propri valori ad accompagnare la capacità di eseguire compiti. Ciò che più manca, forse, in questo libro, è una vera e propria discussione sull’eticità di questo futuro e del presente già in atto.

Le critiche a Bostrom

La principale critica mossa a Superintelligenza è la convinzione sensazionalistica e catastrofistica che indirizza il ragionamento dell’autore. Il lettore stesso, alla fine della lettura, non può che essere “plasmato” da tanto rigore scientifico e trovarsi d’accordo con l’argomentazione rigorosa. Ovviamente, approfondendo la riflessione sul testo, sono riscontrabili diversi eccessi.

Una conclusione vera, per essere tale, deve poggiarsi su un certo tipo di premesse. In Superintelligenza, molte delle premesse alle argomentazioni di Bostrom si poggiano invece su asserti ipotetici e difficilmente dimostrabili. Bostrom in un certo senso da per scontato la certezza e la fattibilità di alcune innovazioni e recenti scoperte. Tutto ciò che ne segue deve quindi essere preso con le pinze. Alcuni filoni di pensiero sostengono addirittura che un’eventualità quale quella teorizzata da Bostrom sia ad oggi del tutto non soppesabile: non vi sono abbastanza elementi per farlo.

Pertanto, ciò che da un certo punto di vista è il contenuto di Superintelligenza, è un incontro di fatti e ricerche scientifiche selezionati per il loro filo comune, ovvero la probabilità di svilupparsi poi in super IA. Da ciò Bostrom innalza un castello di se e possibili strategie per affrontarli. A tratti è dunque più fantascienza, che scienza nel senso stretto del temine.

La necessità dell’informazione

In merito alle critiche, va ricordata la consapevolezza dell’autore, che nello stesso libro scrive:

Molte delle affermazioni di questo libro probabilmente sono sbagliate.

Il lavoro di Bostrom ha il merito indiscusso di tentare di informare su vasta scala rispetto alle nuove tendenze di ricerca e ai rischi che possono nascondersi in esse. Questo intento ha una grande rilevanza. Ricordiamo che la maggior parte delle informazioni e delle decisioni in merito alle tecnologie d’avanguardia sono gestite da industrie private, che non appellano in alcun modo la sfera pubblica della società. Ma sarà proprio la società, presa interamente, a fare i conti con questi sviluppi, in un futuro possibile.

La civetta di Minerva

Ora, una piccola curiosità. Non a caso nella copertina di Superintelligenza è posta una civetta, simbolo della filosofia e della saggezza dai tempi della antica cultura greca e romana. Veniva infatti chiamata civetta (o “nottola”) di Minerva (o di Atena). Rappresentativamente, gli occhi e il becco della civetta formano la lettera greca φ (fi): simbolo della filosofia, l’amore per la conoscenza, la ricerca. Più tardi, divenne simbolo anche della sezione aurea.

Nel caso dell’opera di Bostrom qui discussa, ritengo la presenza della civetta di Minerva profondamente legata alla interpretazione che Hegel diede a questo simbolo. Ovvero, la filosofia è intesa come ricerca che giunge alla comprensione della situazione storica quando quest’ultima si è conclusa: come la civetta che spicca il volo solo al crepuscolo, quando il sole è già tramontato.

Per dire ancora una parola a proposito del dare insegnamenti su come dev’essere il mondo, ebbene, per tali insegnamenti in ogni caso la filosofia giunge sempre troppo tardi. In quanto pensiero del mondo essa appare soltanto dopo che la realtà ha compiuto il suo processo di formazione e s’è bell’e assestata. Questo, che il concetto insegna, mostra necessario parimenti la storia, che soltanto nella maturità della realtà l’ideale appare di fronte al reale e che quell’ideale si costruisce il medesimo mondo, appreso nella sostanza di esso, dandogli la figura d’un regno intellettuale. Quando la filosofia dipinge il suo grigio su grigio, allora una figura della vita è invecchiata; e con grigio su grigio essa non si lascia ringiovanire, ma soltanto conoscere; la nottola di Minerva inizia il suo volo soltanto sul far del crepuscolo.

Hegel, Prefazione, in Lineamenti di filosofia del diritto

Bostrom riconosce il cambiamento in corso e in parte già avvenuto nella nostra società: stiamo quasi per spiccare il salto verso un nuovo tipo di mondo e società. Per quanto ancora ci appaiano incerti, rifletterci non può che renderci più consapevoli.